如何解決java網絡爬蟲連接超時的問題

這篇文章將為大家詳細講解有關如何解決java網絡爬蟲連接超時的問題,小編覺得挺實用的,因此分享給大家做個參考,希望大家閱讀完這篇文章后可以有所收獲。

成都創新互聯主要業務有網站營銷策劃、成都網站設計、做網站、成都外貿網站建設公司、微信公眾號開發、微信小程序定制開發、HTML5建站、程序開發等業務。一次合作終身朋友,是我們奉行的宗旨;我們不僅僅把客戶當客戶,還把客戶視為我們的合作伙伴,在開展業務的過程中,公司還積累了豐富的行業經驗、成都全網營銷資源和合作伙伴關系資源,并逐漸建立起規范的客戶服務和保障體系。

具體如下。

在網絡爬蟲中,經常會遇到如下報錯。即連接超時。針對此問題,一般解決思路為:將連接時間、請求時間設置長一下。如果出現連接超時的情況,則在重新請求【設置重新請求次數】。

Exception in thread "main" java.net.ConnectException: Connection timed out: connect

下面的代碼便是使用httpclient解決連接超時的樣例程序。直接上程序。

package daili;

import java.io.IOException;

import java.net.URI;

import org.apache.http.HttpRequest;

import org.apache.http.HttpResponse;

import org.apache.http.client.ClientProtocolException;

import org.apache.http.client.methods.HttpGet;

import org.apache.http.client.params.CookiePolicy;

import org.apache.http.client.protocol.ClientContext;

import org.apache.http.impl.client.BasicCookieStore;

import org.apache.http.impl.client.CloseableHttpClient;

import org.apache.http.impl.client.DefaultHttpClient;

import org.apache.http.impl.client.DefaultHttpRequestRetryHandler;

import org.apache.http.impl.client.HttpClients;

import org.apache.http.impl.cookie.BasicClientCookie2;

import org.apache.http.params.HttpConnectionParams;

import org.apache.http.params.HttpParams;

import org.apache.http.protocol.BasicHttpContext;

import org.apache.http.protocol.ExecutionContext;

import org.apache.http.protocol.HttpContext;

import org.apache.http.util.EntityUtils;

/*

* author:合肥工業大學 管院學院 錢洋

*1563178220@qq.com

*/

public class Test1 {

public static void main(String[] args) throws ClientProtocolException, IOException, InterruptedException {

getRawHTML("http://club.autohome.com.cn/bbs/forum-c-2098-1.html#pvareaid=103447");

}

public static String getRawHTML ( String url ) throws ClientProtocolException, IOException, InterruptedException{

//初始化

DefaultHttpClient httpclient = new DefaultHttpClient();

httpclient.getParams().setParameter("http.protocol.cookie-policy",

CookiePolicy.BROWSER_COMPATIBILITY);

//設置參數

HttpParams params = httpclient.getParams();

//連接時間

HttpConnectionParams.setConnectionTimeout(params, 6000);

HttpConnectionParams.setSoTimeout(params, 6000*20);

//超時重新請求次數

DefaultHttpRequestRetryHandler dhr = new DefaultHttpRequestRetryHandler(5,true);

HttpContext localContext = new BasicHttpContext();

HttpRequest request2 = (HttpRequest) localContext.getAttribute(

ExecutionContext.HTTP_REQUEST);

httpclient.setHttpRequestRetryHandler(dhr);

BasicCookieStore cookieStore = new BasicCookieStore();

BasicClientCookie2 cookie = new BasicClientCookie2("Content-Type","text/html;charset=UTF-8");

BasicClientCookie2 cookie1 = new BasicClientCookie2("User-Agent","Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/52.0.2743.116 Safari/537.36");

cookieStore.addCookie(cookie);

cookieStore.addCookie(cookie1);

localContext.setAttribute(ClientContext.COOKIE_STORE, cookieStore);

HttpGet request = new HttpGet();

request.setURI(URI.create(url));

HttpResponse response = null;

String rawHTML = "";

response = httpclient.execute(request,localContext);

int StatusCode = response.getStatusLine().getStatusCode();

//獲取響應狀態碼

System.out.println(StatusCode);

if(StatusCode == 200){

//狀態碼200表示響應成功

//獲取實體內容

rawHTML = EntityUtils.toString (response.getEntity());

System.out.println(rawHTML);

//輸出實體內容

EntityUtils.consume(response.getEntity());

//消耗實體

} else {

//關閉HttpEntity的流實體

EntityUtils.consume(response.getEntity());

//消耗實體

Thread.sleep(20*60*1000);

//如果報錯先休息30分鐘

}

httpclient.close();

System.out.println(rawHTML);

return rawHTML;

}

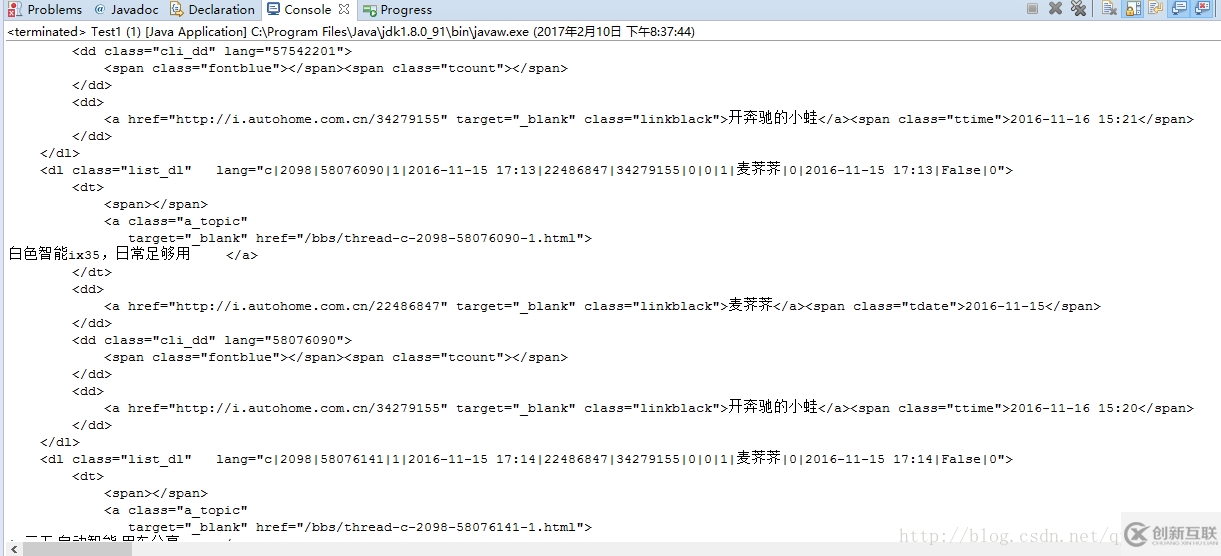

}結果:

關于“如何解決java網絡爬蟲連接超時的問題”這篇文章就分享到這里了,希望以上內容可以對大家有一定的幫助,使各位可以學到更多知識,如果覺得文章不錯,請把它分享出去讓更多的人看到。

網頁名稱:如何解決java網絡爬蟲連接超時的問題

當前URL:http://www.yijiale78.com/article40/igshho.html

成都網站建設公司_創新互聯,為您提供網站設計公司、域名注冊、品牌網站建設、外貿建站、做網站、網站建設

聲明:本網站發布的內容(圖片、視頻和文字)以用戶投稿、用戶轉載內容為主,如果涉及侵權請盡快告知,我們將會在第一時間刪除。文章觀點不代表本網站立場,如需處理請聯系客服。電話:028-86922220;郵箱:631063699@qq.com。內容未經允許不得轉載,或轉載時需注明來源: 創新互聯

- 網站整站優化和關鍵詞優化有什么不同 2014-04-22

- 創新互聯介紹影響SEO流量的幾點因素 2023-05-05

- 讀懂關鍵詞優化技巧讓企業優先占領商機 2023-03-28

- seo怎么優化?seo關鍵詞優化的技巧 2016-08-24

- 網站關鍵詞優化-選對關鍵詞可以提升你的網站排名 2016-11-11

- 網站關鍵詞優化?怎么提升 2014-08-12

- 企業網站制作過程中核心關鍵詞優化策略 2021-08-14

- 成都網絡推廣優化有些關鍵詞優化技巧? 2023-04-16

- 網站長尾關鍵詞優化七大技巧 2016-01-01

- 關鍵詞優化需要做哪些工作? 2015-06-25

- 網絡優化主要做什么?百度推廣關鍵詞優化策略指導 2022-09-02

- 為什么做了關鍵詞優化沒有排名,是什么原因導致? 2023-04-14